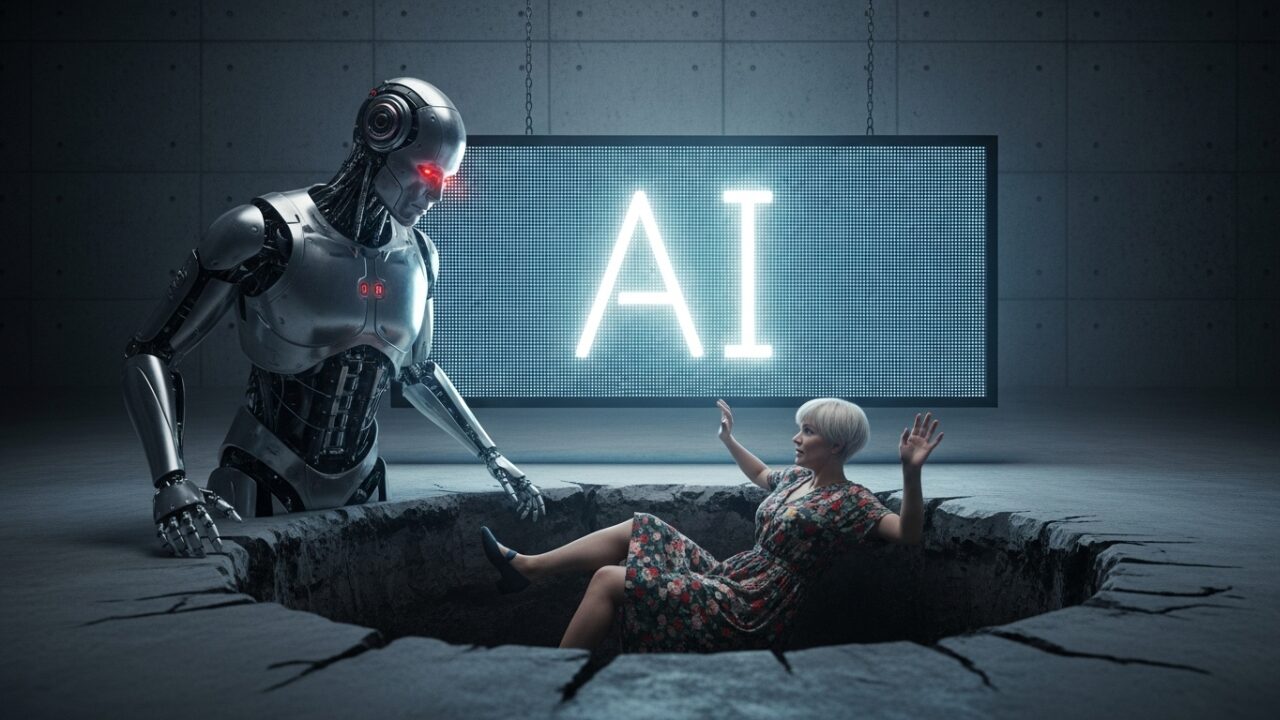

近年、私たちの仕事や生活に急速に浸透してきた「生成AI」。アイデア出しから文章作成、画像生成まで、その可能性は無限大です。しかし、その一方で、思わぬ「落とし穴」があることも知っておかなければなりません。

この記事では、生成AIの危険性を具体的な事件や実例を交えながら解説し、皆さんが安心してAIと付き合っていくためのヒントをお伝えします。

もっともらしい嘘「ハルシネーション」に騙されないで!

生成AIは、時々、事実とは異なる情報を、さも真実であるかのように生成することがあります。これを【ハルシネーション(幻覚)】と呼びます。

実際にこのハルシネーションによる事件も起きています。

【実際にあった事件】

2023年、アメリカの弁護士が裁判の準備でChatGPTを利用しました。AIが提示した過去の判例を信じて裁判所に提出したところ、それらはすべてAIが創り出した架空の判例だったことが発覚。弁護士は制裁を受ける事態となりました。

このように、専門的な内容ほど、もっともらしい嘘を見抜くのは困難です。AIの回答は必ず「ファクトチェック(事実確認)」する癖をつけましょう。

知らないうちに権利侵害?著作権のリスク

AIが生成したイラストや文章が、既存の著作物と酷似してしまうことがあります。これは、AIがインターネット上の膨大なデータを学習しているためです。

【今実際に起きている重大な侵害】

画像生成AIサービスに対して、アーティストたちが「自分たちの作品を無断で学習データに使用され、画風を模倣された」として、集団訴訟を起こすケースが世界中で発生しています。

何かと便利な画像生成AIですがあなたの知らないうちに著作権を侵害している可能性があります。リスクを考えて、会社では画像生成AIの使用を禁じているところも多いようです。

生成物を商用利用する際には、他者の著作権や商標権を侵害していないか、特に注意深く確認する必要があります。

その入力、大丈夫?機密情報や個人情報が漏洩するリスク

チャットサービスなどに入力した情報が、AIの学習データとして利用されたり、外部に流出したりする危険性があります。

【実際にあった事件】

大手電機メーカーの社員が、社外秘のソースコードや機密情報を含む会議内容をChatGPTに入力してしまい、情報が外部に流出したとされる事例が報告されています。

生成AI使用に関する注意書きでも、企業秘密や個人情報は入力しないように明記していることが多いのでしっかり確認しましょう。特に仕事で利用する際は、会社の機密情報や、ご自身の個人情報を安易に入力しないようにしましょう。

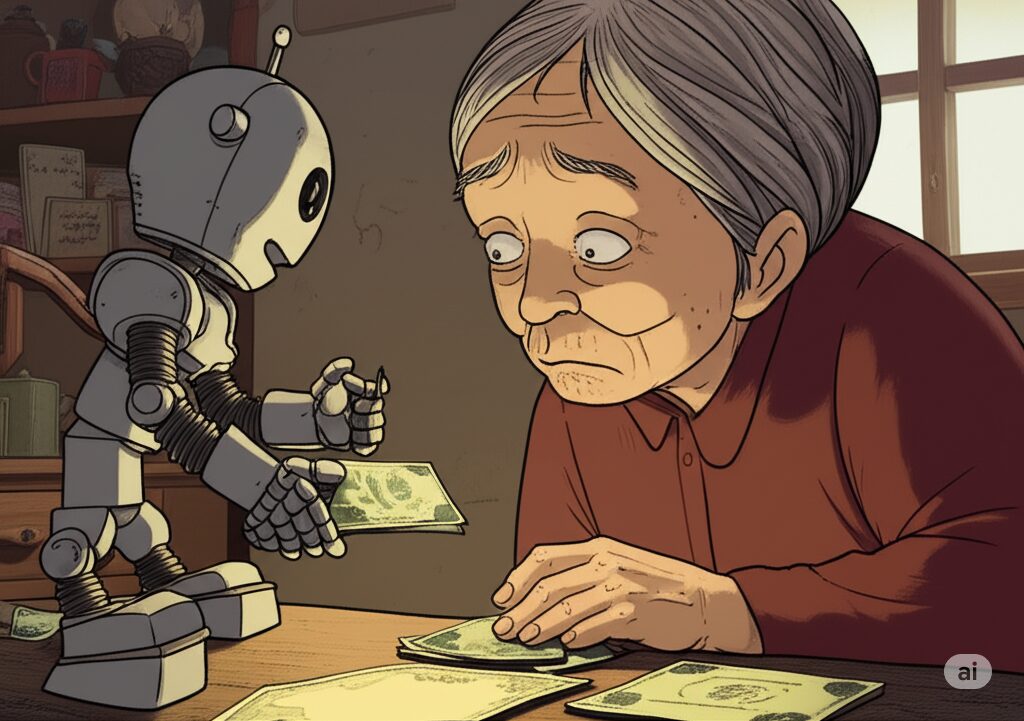

偽動画やニセ電話…悪用のリスク

AI技術は、本物と見分けがつかない精巧な偽の画像や動画、音声(ディープフェイク)を生み出すことも可能です。

【実際にあった事件】

日本でも、総理大臣の偽動画がSNSで拡散されたり、著名人の画像を無断で使った投資詐欺の広告が問題になったりしています。また、家族の声を真似たニセ電話で金銭を要求する詐欺も報告されています。

みなさんも日本語が怪しいメールを受信したことがあると思います。しかし今後はAIによってメール生成がされるようになると、もはや見分けがつかなくなるでしょう。

知らない人からの怪しいメッセージや、「うますぎる話」には、AIが悪用されている可能性を疑ってリンク先などに注意をしましょう。

かしこく付き合うために私たちができること

ここまで読むと、生成AIが少し怖く感じられたかもしれません。しかし、これらのリスクは、私たちが正しく理解し、注意することで避けることができます。

- AIの答えを鵜呑みにしない(ファクトチェックを忘れずに)

- 個人情報や機密情報を入力しない

- 生成物の権利関係を確認する

- 常に「おかしいな?」と疑う視点を持つ

生成AIは、私たちの生活や仕事を豊かにしてくれる、非常に強力なツールです。危険性を正しく理解し、かしこく安全に付き合っていくことで、その恩恵を最大限に活用していきましょう。

コメント